如今,企业处理大数据的方式正在迅速发生改变。短短几年前,大数据只是一个热门的流行语,大多数组织都在尝试使用Hadoop和相关技术。如今,大数据技术,特别是大数据分析已经演变成为大多数企业战略的重要组成部分,企业面临着紧跟大数据快速发展的巨大压力。

NewVantage公司开展的2018年合作伙伴的大数据高管调查表明,发现大数据项目以及这些项目带来的收益几乎变得很普遍。在受访者中,有97.2%的高管表示他们的公司正在实施大数据或人工智能(AI)计划,98.6%的人表示他们的公司正试图创建一个数据驱动文化,而2017年这个数字为85.5%。绝大多数的受访者(73%)表示,他们已经通过大数据举措获得了可衡量的价值。

由供应商AtScale公司独立进行的2018年大数据成熟度调查发现,66%的组织认为大数据具有战略性或改变游戏规则,而只有17%的组织认为该技术是实验性的。另外,95%的受访者表示,计划在未来三个月内使用大数据开展更多的工作。

但他们对大数据究竟会做些什么呢?

一系列不同的趋势正在影响大数据举措,但四个总体主题正在成为2018年影响大数据的关键因素:云计算、机器学习、数据治理,以及对速度的需求。

1.云计算

分析师认为,大数据正在向云计算迈进。调研机构Forrester公司的Brian Hopkins表示:“通过云订阅的全球大数据解决方案支出增长速度将比内部订阅订单快7.5倍。此外,根据2016年和2017年的数据调查,公共云是大数据分析专业人员的首要技术优先事项。”他表示,通过公共云服务提供的成本优势和创新将对大多数企业来说无法抗拒。

而一些调查似乎支持这些结论:

在AtScale公司的调查报告中,59%的受访者表示他们已经在云中部署了大数据,77%的受访者预计其部分或全部大数据部署将在云中。

Teradata公司云计算状况分析报告发现,对基于云计算的大数据分析的需求更高。38%的受访者表示,云端是运行分析的最佳场所,69%的受访者表示他们希望在2023年之前在云平台中运行所有分析。

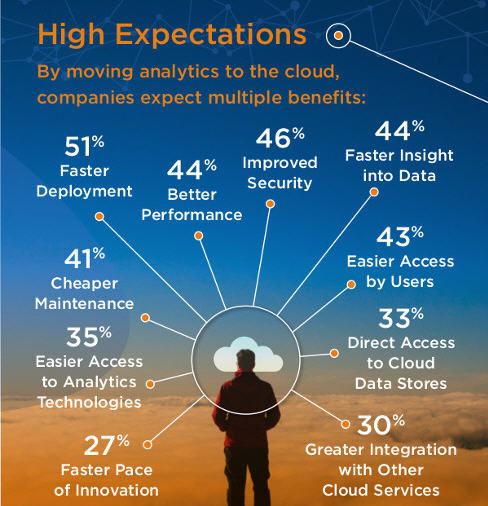

他们为什么如此热切地转向云端?云计算分析的预期收益包括更快的部署(51%),更高的安全性(46%),更好的性能(44%),更快的数据洞察力(44%),用户更容易访问(43%),成本更低的维护(41%)。

组织将继续将其数据存储迁移到公共云提供商的云服务中,并且当数据已经驻留在云中时,在云中执行大数据分析的速度也会更快、更轻松,成本更低。

另外,许多云计算提供商提供人工智能和机器学习工具,使云计算更具吸引力。

2.机器学习和人工智能

机器学习是人工智能的一个重要组成部分,它在没有被计算机明确编程的情况下学习,它与大数据分析有着内在联系,因此这两个术语有时会混合在一起。事实上,今年NewVantage公司年度大数据调查的封面已经重新设计,以显示它包含大数据和人工智能。

调查报告的作者写道:“大数据和人工智能项目几乎难以区分,特别是考虑到机器学习是处理大量快速移动数据的最流行技术之一。”

当这项调查要求管理人员选择哪种大数据技术会产生最大的颠覆性影响时,71.8%的受访者选择的最多选项是人工智能。与2017年相比,这是一个显著的增长,当时只有44.3%的受访者表示同样的观点。尤其值得注意的是,人工智能远远领先于云计算(12.7%)和区块链(7.0%)。

调查机构Gartner公司研究副总裁John-David Lovelock的观点与这些高管达成一致。 “由于计算能力、数量、速度和各种数据的进步,以及深度神经网络(DNNs)的发展,人工智能在未来10年内承诺将成为最具颠覆性的技术类别。”他表示。

Gartner公司最近进行的预测表明,“从人工智能(AI)获得的全球商业价值预计在2018年将达到1.2万亿美元,比2017年增长70%。”展望未来,Gartner公司分析师补充说:“预测2022年人工智能的商业价值将达到3.9万亿美元。”

考虑到潜在的商业价值,企业计划大量投资于机器学习和相关技术并不令人惊讶。据调研机构IDC公司称,“2018年全球认知与人工智能(AI)系统支出将达到191亿美元,比2017年的支出增长54.2%。”

3.数据治理

但是,虽然云计算和机器学习带来的潜在收益正在推动企业投资这些大数据技术,但企业仍然面临着与大数据相关的重大障碍。

其中最重要的一点是如何确保所有数据的准确性、可用性、安全性和合规性。

当AtScale公司的调查要求受访者指出他们面临的与大数据相关的最大挑战时,治理是排在第二位,仅落后于技能组合,而这是每年调查中所提出的头号挑战。早在2016年,治理只位列挑战清单的底部,因此其升至第二位,其变化尤其显著。组织现在更关心数据治理,而不是性能、安全或数据管理。

重新引起人们关注的部分原因可能是最近发生的Facebook公司和英国剑桥分析的数据泄露丑闻。这个违规事件非常清楚地表明,潜在的公共关系噩梦可能会由于失去数据的正常发展轨迹而发生,并且无法正确保护用户的隐私。

欧盟颁布的通用数据保护条例(GDPR)是今年5月生效的另一大变革力量。它要求所有拥有欧盟公民的数据的组织都能够满足某些要求,例如违规通知、访问权限、被遗忘权利、数据可移植性、设计隐私,以及任命数据保护人员。

监管变革给组织带来了越来越大的压力,以确保他们知道自己拥有哪些数据以及驻留在哪里,并确保正确地保护这些数据。这是一项艰巨的任务,需要很多企业加紧制定,并重新思考他们的大数据战略。

4.速度的需要

与此同时,他们感到需要放缓处理数据治理问题的速度,许多企业也有对更快速的大数据分析的需求。

在NewVantage公司的调查中,47.8%的管理人员表示,他们主要使用大数据的原因是近实时的、日常仪表板和操作报告,或者是实时互动,或者是面向客户的流媒体,或者是关键任务应用。这是一个重要的发展,因为数据分析的传统用途是每天、每周或每月执行批量报告。

同样,Syncsort公司的调查发现,60.4%的受访者对实时分析感兴趣。

为了满足实时或接近实时性能的需求,企业越来越倾向于使用内存技术。由于处理内存(RAM)中的数据比访问存储在硬盘驱动器或固态硬盘驱动器上的数据快得多,因此内存技术可以显著提高速度。

事实上,SAP公司宣称其专有的HANA技术已帮助一些公司加快业务流程的速度达到原来的10000倍。尽管大多数公司没有体验到这种性能提升,但SAP公司并不是唯一一家在内存技术方面做出巨大贡献的公司。Apache Spark是一款运行在内存中的开源大数据分析引擎,它宣称可以运行比标准Hadoop引擎快100倍的工作负载。

企业似乎注意到这些性能改进。供应商Qubole报告说,2017年至2018年期间Apache Spark在计算时间方面的用量增长了298%。当人们查看在Apache Spark上运行的命令数量时,其增长更加令人印象深刻,2017年至2018年间在Spark上运行的命令总数提高了439%。

在某些方面,对速度的这种需求也推动了其他三大数据宏观趋势的发展。其部分原因是组织将大数据迁移到云中,因为他们希望获得性能提升。他们至少在一定程度上投资于机器学习和人工智能,因为他们希望获得更快、更好的见解。他们正在经历与数据治理和合规性相关的挑战,至少部分原因在于他们如此快速地接受大数据技术,而没有首先解决所有数据质量、隐私、安全和合规性问题。

在不久的将来,随着企业寻找新的方式来利用大数据颠覆他们的行业。并获得竞争优势,预计所有这四种趋势将会持续并加快发展。